2. 湖南医药学院第一附属医院, 怀化 418099

胸腹部内脏破裂和(或)血管断裂造成的隐匿性出血是创伤救治面临的难点和痛点,是导致患者发生失血性休克甚至死亡的重要原因[1-4]。因此,快速、准确地检测胸腹部是否存在出血对于创伤临床救治至关重要。创伤超声重点评估(focused assessment with sonography for trauma,FAST)因其无创性、实时性、低成本和便携性等优势,在院前急救、院内急诊和重症监护中已被广泛应用[5],尤其适用于危重患者的动态监测。对超声图像进行人工智能识别有助于快速判断出血。识别的第一步是对图像进行分割,传统的超声图像分割方法主要依赖于图像处理技术,如轮廓检测、聚类、区域生长、边缘检测等[6-8]。近年来,随着深度学习技术的快速发展,如基于卷积神经网络(CNN)、全卷积网络(UNet)和基于扩散模型的图像分割框架等技术已在超声领域逐步应用[9-13],但用于胸腹部创伤超声的图像分割方法还尚未见到有关报道。为此,本研究旨在研究探索一种超声图像分割方法,实现对创伤患者胸腹部出血区域的自动定位,为实现创伤超声FAST智能化诊断提供辅助决策支持奠定基础。

1 资料与方法 1.1 研究对象本研究采用回顾性研究,筛选2022年1月1日至2024年12月31日期间北京急救中心和湖南医药学院第一附属医院救治的创伤患者,收集患者胸腹部超声图像,纳入病例超声图像清晰,出血区域与周围正常组织边界清楚、无伪影。本研究符合医学伦理学标准,并通过北京急救中心伦理委员会审查批准(2024-09-003)。

1.2 研究方法 1.2.1 图像预处理对于每张胸腹部超声出血的原始超声图像(图 1A),由超声科医生标注出血范围标注图像(图 1B),通过比较原始超声图像和标注图像之间的颜色差异,并做二值化,形态学滤波、连通区域提取操作,生成超声出血区域的掩码图像(图 1C),其中白色为出血区域,黑色为背景。

|

| A: 图像B: 标注C: 掩码 图 1 原始超声图像、标注图像和生成的掩码图像 |

|

|

本研究采用UNet、UNet++、ResUNet、DenseUNet、Rolling UNet和CIMD六种不同的图像分割深度学习模型进行比较。

UNet[14]是一种全卷积网络(Fully Convolutional Network, FCN),其结构由对称的编码器和解码器组成,中间通过跳跃连接相连。这种网络因其高效的分割性能和对小样本数据的良好适应性,被广泛应用于医学图像处理。

UNet++[15-16]是U-Net的改进版本,其核心结构包括多个级联的U-Net子网络,通过密集跳跃连接逐步优化特征映射,使得不同尺度的特征能够更充分地融合。

ResUNet[17-18]结合了ResNet和U-Net结构,其核心特点是在U-Net中引入残差块,通过跳跃连接缓解梯度消失问题,确保了特征在不同层级间的有效传递和融合,进一步提升了模型的分割精度。

DenseUNet[19]结合了DenseNet和U-Net结构。其核心特点是在U-Net中引入密集连接,增强特征共享,提高信息流通性。DenseUNet继承了U-Net的对称跳跃连接,同时利用DenseNet结构减少冗余参数,提高训练效率。

RollingUNet[20]是一种改进的U-Net变体,采用循环滑动策略来增强全局信息捕获能力。其核心思想是在U-Net基础上引入滚动窗口机制,使得输入图像在不同空间位置进行滑动,从而提升模型对局部图像和全局特征的学习能力。

CIMD[21]是一种基于扩散模型的图像分割框架,包含两个关键模块的分割框架:模糊性建模网络负责捕获输入图像与其真实分割之间的模糊性;模糊性控制网络控制预测分割掩码的模糊性分布。

1.2.3 参数设置与验证按照4∶1的比例,将所有图像随机分为训练组和测试组。在训练组训练分割模型,在测试组评估分割模型的性能。采用Python作为开发语言,使用PyTorch 1.21.1深度学习框架进行模型的搭建与训练(GPU使用NVIDIA V100显卡一张,16GB显存),批量大小(Batch Size)对所有模型均设置为8,以平衡显存使用和模型性能;迭代次数(Epochs)设置为200;优化器(Optimizer)使用Adam优化器进行模型参数更新;学习率(Learning Rate)初始设置为0.0001,并采用学习率衰减策略。

1.2.4 评估指标本研究采用Dice系数[22](Dice Coefficient)和交并比(Intersection over Union, IoU)[23]两种方法进行评价。

Dice系数是一种用于衡量两个样本集合相似度的统计指标,计算公式为,

| $ \text { Dice }=\frac{2|\mathrm{~A} \cap \mathrm{~B}|}{|\mathrm{A}|+|\mathrm{B}|} $ |

其中A和B分别代表预测分割结果与真实标签。Dice系数值的范围为0到1,值越接近1,代表分割效果越好。

交并比IoU通过计算预测分割区域与真实分割区域的交集与并集之比来衡量模型的分割精度,公式为,

| $ \mathrm{IoU}=\frac{|\mathrm{A} \cap \mathrm{~B}|}{|\mathrm{A} \cup \mathrm{~B}|} $ |

IoU的取值为0到1之间,值越大代表模型在分割任务中的效果越好。

2 结果 2.1 一般情况本研究共纳入875张创伤患者胸腹部超声图像,其中胸部625张、腹部250张;有出血564张(胸部400张、腹部164张)、无出血311张(胸部225张、腹部86张)。

2.2 评估指标胸部测试组UNet、UNet++、ResUNet、DenseUNet、Rolling UNet和CIMD 6种测试方法的Dice、IoU系数见表一,其中,CIMD方法性能在胸腹部两种评估指标中均高于其他五种方法。

| 模型 | 胸部 | 腹部 | ||

| Dice | IoU | Dice | IoU | |

| UNet | 0.795 | 0.618 | 0.587 | 0.411 |

| UNet++ | 0.797 | 0.627 | 0.594 | 0.428 |

| ResUNet | 0.795 | 0.641 | 0.573 | 0.413 |

| DenseUNet | 0.781 | 0.659 | 0.581 | 0.436 |

| RollingUNet | 0.817 | 0.795 | 0.651 | 0.585 |

| CIMD | 0.866 | 0.807 | 0.751 | 0.702 |

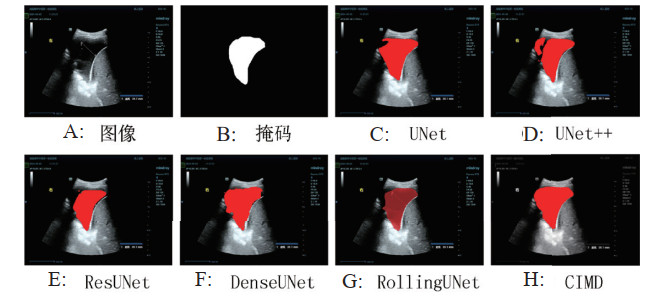

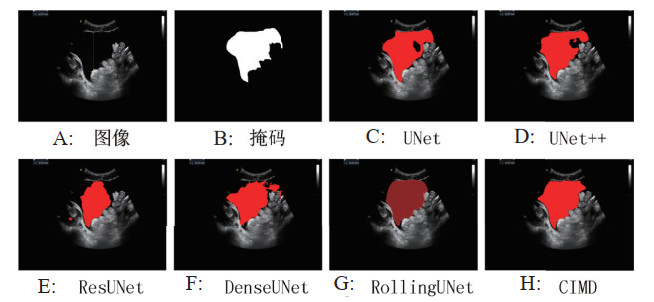

图 2和图 3分别展示了一组胸部和腹部超声FAST图像分割结果,其中A为超声图像,B为由医生标注生成的出血区域掩码,C~H为六种图像分割模型的分割结果。红色区域为每种模型的分割结果,可以看出,CIMD方法的分割结果更接近真实的出血区域。

|

| 图 2 胸部分割结果可视化图像 |

|

|

|

| 图 3 腹部分割结果可视化图像 |

|

|

创伤超声FAST检查及诊断结果解读主要依靠急诊科医师或超声专科医师, 不仅耗时, 还限制了超声在缺乏专业超声医生等领域, 尤其是院前急救领域的应用,且诊断结果易受医师主观影响, 标准无法统一[5]。因此, 本研究采用深度学习技术,探索图像分割算法在创伤患者胸腹部出血超声FAST的自动定位和辅助诊断,为实现创伤超声FAST智能化诊断提供辅助决策支持提供科学依据。

本研究结果表明,胸部测试组性能分析,6种方法展现出了不同的表现。Dice系数反应出UNet、UNet++、ResUNet在胸部图像分割的准确性上处于相似水平。CIMD的Dice系数较高,表明其能更精确的识别和分割胸部组织。IoU指标方面,CIMD同样显著高于其他方法。进一步证实了其在胸部图像分割任务中,对目标区域定位和分割范围把握的优越性。腹部测试组的结果与胸部测试组类似,CIMD在腹部测试中同样展现出对目标区域更好的重叠匹配能力。

综合胸部和腹部测试结果,CIMD方法在Dice系数和IoU指标上均显著优于其他五种方法。这可能归因于CIMD独特的算法结构或对图像特征的有效提取与利用。其能够更好地处理胸部和腹部复杂的解剖结构及图像特征,准确识别目标组织边界,从而实现更精准的分割。然而,本研究仅在胸部和腹部图像上进行了测试,未来需进一步拓展到其他部位及更多样化的医学图像类型,以全面验证CIMD方法的普适性和稳定性。同时对CIMD方法内部机制的深入研究,通过人工智能如何进一步提升模型的性能、降低计算复杂度、提高实时性能、减少人为的差异等仍是未来研究的重要方向。在AI技术的不断推动下,图像分割领域有广阔的发展前景。

利益冲突 所有作者声明无利益冲突

作者贡献声明 田思佳、牛升梅:论文撰写;杨忠诚:数据收集、统计学分析;张克云、张进军:研究设计、论文修改

| [1] | 牛升梅, 朱蕗颖, 张进军. 创伤大出血快速识别与诊断的研究进展[J]. 中华急诊医学杂志, 2025, 34(1): 117-122. DOI:10.3760/cma.j.issn.1671-0282.2025.01.022 |

| [2] | 中国医师协会急诊医师分会, 解放军急救医学专业委员会, 北京急诊医学学会, 等. 院前创伤急救止血专家共识(2025年版)[J]. 中华急诊医学杂志, 2025, 34(4): 469-477. DOI:10.3760/cma.j.issn.1671-0282.2025.04.003 |

| [3] | Li R, Zhou J, Huang W, et al. Murine model for investigating severe trauma[J]. World J Emerg Med, 2025, 16(4): 321. DOI:10.5847/wjem.j.1920-8642.2025.082 |

| [4] | Kang YB, Yang Q, Ding HB, et al. Analysis of risk factors for trauma-induced coagulopathy in elderly major trauma patients[J]. World J Emerg Med, 2024, 15(6): 475-480. DOI:10.5847/wjem.j.1920-8642.2024.093 |

| [5] | 洪玉才, 张茂, 何小军, 等. 急诊床旁应用超声FAST方案快速评估多发伤的初步研究[J]. 中华急诊医学杂志, 2010, 19(10): 1066-1069. DOI:10.3760/cma.j.issn.1671-0282.2010.10.017 |

| [6] | Rai R. Deep learning in image segmentation for cancer[J]. J Med Radiat Sci, 2024, 71(4): 505-508. DOI:10.1002/jmrs.839 |

| [7] | Smith R, Murphy L, Pretty CG, et al. Tube-load model: a clinically applicable pulse contour analysis method for estimation of cardiac stroke volume[J]. Comput Meth Programs Biomed, 2021, 204: 106062. DOI:10.1016/j.cmpb.2021.106062 |

| [8] | Friebel A, Johann T, Drasdo D, et al. Guided interactive image segmentation using machine learning and color-based image set clustering[J]. Bioinformatics, 2022, 38(19): 4622-4628. DOI:10.1093/bioinformatics/btac547 |

| [9] | 向卓, 陈伟玲, 田晓雨, 等. 关键点引导的时序网络用于超声心动图分割[J]. 中国生物医学工程学报, 2024, 43(6): 641-651. DOI:10.3969/j.issn.0258-8021.2024.06.001 |

| [10] | 朱彦华. 基于改进CNN的弱边缘超声图像分割方法[J]. 吉林大学学报(信息科学版), 2024, 42(6): 1018-1024. DOI:10.3969/j.issn.1671-5896.2024.06.004 |

| [11] | 宋艳涛, 路云里. SwinT-Unet: 基于双通道自注意力机制的超声图像分割方法[J]. 电子学报, 2024, 52(11): 3835-3846. DOI:10.12263/DZXB.20230904 |

| [12] | 王雷, 郭新萍, 王钰帏, 等. 基于DRA-UNet模型的超声图像分割方法[J]. 华中科技大学学报(自然科学版), 2024, 52(5): 83-89. DOI:10.13245/j.hust.240423 |

| [13] | 李佳松, 曹洪帅, 舒丽霞, 等. 基于Transformer的血管内超声图像分割方法[J]. 北京生物医学工程, 2023, 42(1) 16-20, 51. DOI:10.3969/j.issn.1002-3208.2023.01.003 |

| [14] | Noothout JMH, Lessmann N, van Eede MC, et al. Knowledge distillation with ensembles of convolutional neural networks for medical image segmentation[J]. J Med Imaging (Bellingham), 2022, 9(5): 052407. DOI:10.1117/1.JMI.9.5.052407 |

| [15] | Yin YJ, Xu WZ, Chen L, et al. CoT-UNet++: a medical image segmentation method based on contextual transformer and dense connection[J]. Math Biosci Eng, 2023, 20(5): 8320-8336. DOI:10.3934/mbe.2023364 |

| [16] | Zhan SY, Yuan Q, Lei X, et al. BFNet: a full-encoder skip connect way for medical image segmentation[J]. Front Physiol, 2024, 15: 1412985. DOI:10.3389/fphys.2024.1412985 |

| [17] | Li ZM, Yang L, Shu LQ, et al. Research on CT lung segmentation method of preschool children based on traditional image processing and ResUnet[J]. Comput Math Methods Med, 2022, 2022: 7321330. DOI:10.1155/2022/7321330 |

| [18] | Zheng SK, Huang XW, Chen J, et al. UR-net: an integrated ResUNet and attention based image enhancement and classification network for stain-free white blood cells[J]. Sensors (Basel), 2023, 23(17): 7605. DOI:10.3390/s23177605 |

| [19] | Chen WF, Ou HY, Pan CT, et al. Recognition rate advancement and data error improvement of pathology cutting with H-DenseUNet for hepatocellular carcinoma image[J]. Diagnostics (Basel), 2021, 11(9): 1599. DOI:10.3390/diagnostics11091599 |

| [20] | Li C, Liu XK, Wang H, et al. Fault diagnosis method for centrifugal pumps in nuclear power plants based on a multi-scale convolutional self-attention network[J]. Sensors (Basel), 2025, 25(5): 1589. DOI:10.3390/s25051589 |

| [21] | Dang KK, Wang XY, Hu JX, et al. The association between triglyceride-glucose index and its combination with obesity indicators and cardiovascular disease: NHANES 2003-2018[J]. Cardiovasc Diabetol, 2024, 23(1): 8. DOI:10.1186/s12933-023-02115-9 |

| [22] | Yin XX, Jian YX, Shen J, et al. Focal boundary dice: improved breast tumor segmentation from MRI scan[J]. J Cancer, 2023, 14(5): 717-736. DOI:10.7150/jca.82592 |

| [23] | Zhang ZQ, Liu TY, Fan GJ, et al. Verdiff-net: a conditional diffusion framework for spinal medical image segmentation[J]. Bioengineering (Basel), 2024, 11(10): 1031. DOI:10.3390/bioengineering11101031 |

2025, Vol. 34

2025, Vol. 34